Durch Künstliche Intelligenzen erstellte Bilder erleben einen Boom. Werkzeuge und Dienste wie MidJourney, Stable Diffusion oder Dall-E erstellen Werke anhand einer Textvorgabe. Jan Tißler zeigt dir in diesem Artikel, was damit derzeit möglich ist und wohin die Reise in den nächsten Jahren wahrscheinlich gehen wird.

Diesen Artikel vom März 2022 haben wir zuletzt im Mai 2023 aktualisiert.

Inhaltsverzeichnis

Hintergrund: Die rasante Entwicklung im KI-Bereich

Künstliche Intelligenzen haben in den letzten Jahren teils erstaunliche Fortschritte erzielt. Viele davon sind mithilfe eines massiven Datenschatzes trainiert worden.

Dieser Ansatz funktioniert heute vor allem aus zwei Gründen so gut:

- Die verfügbare Rechenkraft selbst auf mobilen Geräten hat sich enorm gesteigert. Das gilt erst recht für professionell eingesetzte und spezialisierte Computer.

- Daten wie Bilder und Texte, um solche KI-Systeme zu trainieren, haben sich sogar noch mehr vervielfacht – Internet und Digitalisierung sei dank.

Hinzu kommt: Fortgeschrittene Tools der ersten Stunde wie Dall-E waren nur einem kleinen Kreis zugänglich. Der Generator Stable Diffusion ist hingegen quelloffen und kostenlos verfügbar. Das hat eine erheblichen Boom ausgelöst, aber auch etliche Fragen aufgeworfen.

Was können KI-Bildgeneratoren heute?

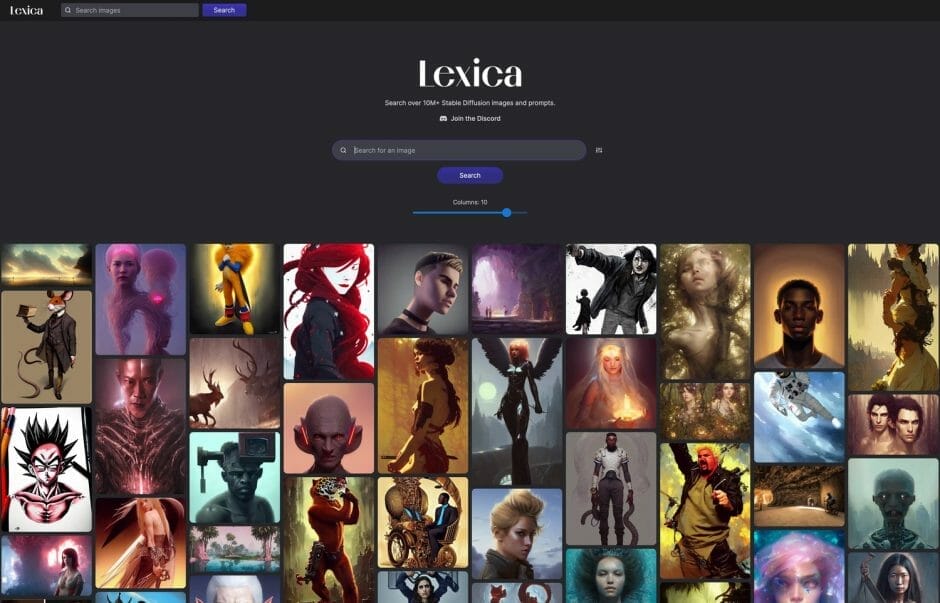

Wenn du das Potenzial einmal selbst erleben möchtest, schau dir die Suchmaschine Lexica an. Sie versammelt Bilder, die mit Stable Diffusion erstellt wurden.

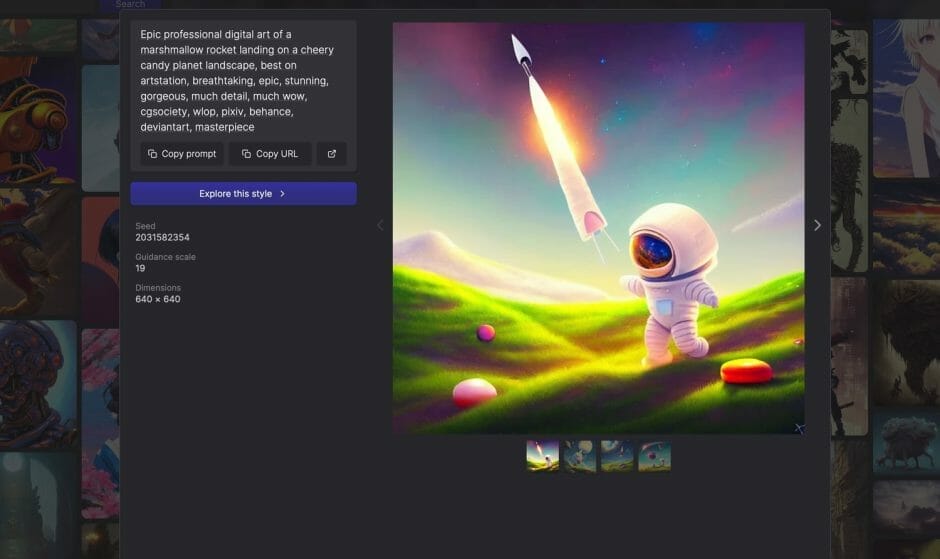

Klickst du auf eines der Bilder, bekommst du weitere Informationen angezeigt. Du siehst etwa, welche Textvorgabe der Ausgangspunkt war. Eine Bildergalerie zeigt dir außerdem Varianten zur selben Vorgabe. Mit einem Klick auf „Explore this style“ siehst du ähnliche Bilder. Oder klicke auf einen der Begriffe aus der Vorgabe und du siehst alle Bilder, die diesen Textbestandteil ebenfalls genutzt haben.

Du wirst schnell feststellen: Die Möglichkeiten sind schier endlos. Du kannst dich problemlos in den Tiefen der Suchergebnisse verlieren. Und in Windeseile kommen weitere Bilder hinzu.

Was du ebenfalls feststellen wirst: Seltsame Effekte und Artefakte gibt es weiterhin. Die faszinierenden Beispielbilder, die du oftmals zum Thema siehst, entstehen nicht wirklich „einfach auf Knopfdruck“. Mehr dazu weiter unten.

Weiterer Linktipp: Das Tool MidJourney präsentiert im „Community Showcase“ eine handverlesene Auswahl der besten Ergebnisse.

Ein anderes bekanntes Tool ist Craiyon, das du ebenfalls kostenlos ausprobieren kannst. Es war ursprünglich unter dem Namen „Dall-E mini“ bekannt. Wartezeiten sind möglich und Einstellungsoptionen gibt es aktuell keine.

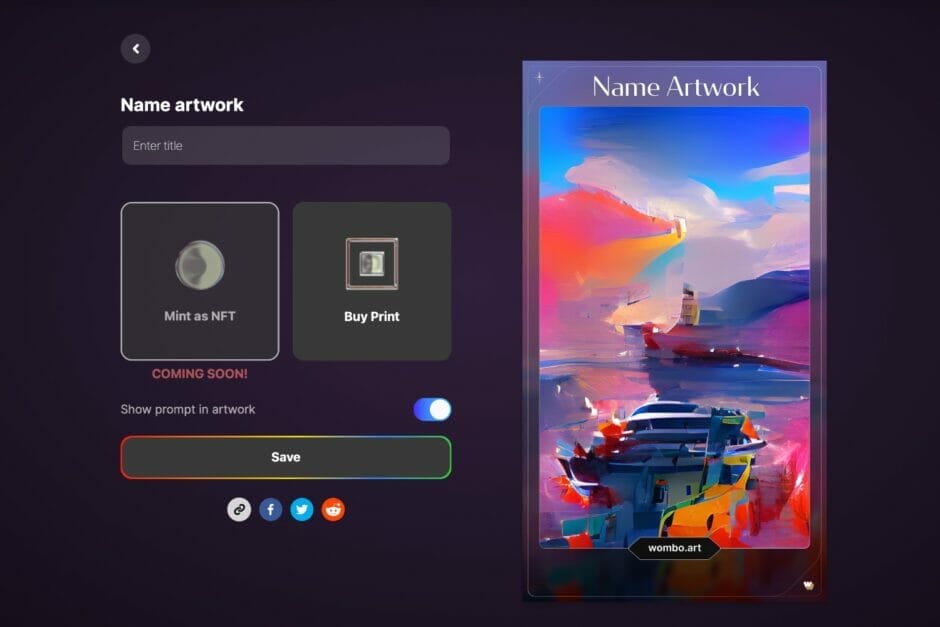

Ein anderes, eher verspieltes Beispiel ist die App „Wombo Dream“. Du kannst sie kostenlos für Android- oder Apple-Geräte herunterladen oder auch direkt im Browser ausprobieren. Du gibst ein Wort oder einen ganzen Satz vor, wählst einen Stil und klickst den Button. Schon generiert dir die KI ein Bild. Gefällt es dir nicht, klickst du den Button erneut.

Bemerkenswert finde ich hier, welche Ergebnisse sich mit abstrakten Vorgaben erzielen lassen.

Willst du eher einmal schauen, was andere so generiert haben, empfehle ich dir GhostlyStock. Gedacht ist es als Seite für kostenlose Stockfotos, bei der alle Bilder per KI-Tools erstellt wurden.

Und bist du vor allem an photorealistischen Bildern interessiert, sollte die Nyx Gallery etwas für dich sein.

Ein letztes, älteres Beispiel sind generierte Porträtfotos. Damit kannst du allerlei Gesichter generieren, die es so nicht gibt. Manche davon haben absurde Artefakte. Viele aber wirken zumindest oberflächlich betrachtet natürlich. Die Macher haben inzwischen Ganzkörperfotos fiktiver Menschen hinzugefügt.

Und wenn du noch mehr ausprobieren möchtest, findest du auf dieser Seite allerlei weitere Spielereien in Text und Bild. Die sind nicht alle so ernst zu nehmen, können aber trotzdem ganz interessant sein.

Vergleichst du die Ergebnisse dieser älteren und einfacheren Werkzeuge mit einem aktuellen Tool wie MidJourney oder Stable Diffusion wird schnell klar, wie dynamisch die Entwicklung in diesem Bereich derzeit ist. Während die Angebote früher eher amüsant als nützlich waren, zeigen die neuesten Werkzeuge wie revolutionär sie sein können. Denn die Entwicklung ist ja nicht am Ende – ganz im Gegenteil. Sie scheint sich aktuell noch zu beschleunigen.

Welche Angebote gibt es?

Stable Diffusion ist aus meiner Sicht ein spannendes Angebot, denn es kann mit anderen aktuellen Generatoren wie Dall-E und MidJourney mithalten und ist zugleich quelloffen und kostenlos nutzbar.

Hierfür hat sich bereits in einem atemberaubenden Tempo eine aktive Szene rund um das Tool entwickelt. So gibt es beispielsweise für aktuelle Macs schnell installierte Apps namens Diffusion Bee und Charl-E. Mindestens 16 GB RAM werden empfohlen. Apples M-Chips für Profis haben hier außerdem die Nase deutlich vorn. Ich persönlich nutze inzwischen DrawThings, das direkt auf dem eigenen Apple-Gerät läuft – ganz ohne Internetzugang oder monatliche Gebühren. Kaum zu glauben: Neben deinem Mac kannst du es ebenso auf iPads und iPhones nutzen. Das ist dann zwar spürbar langsamer, aber mit entsprechend reduzierten Einstellungen immer noch gut nutzbar.

Auf einer eigenen Seite kannst du Stable Diffusion aber auch ganz einfach kostenlos testen.

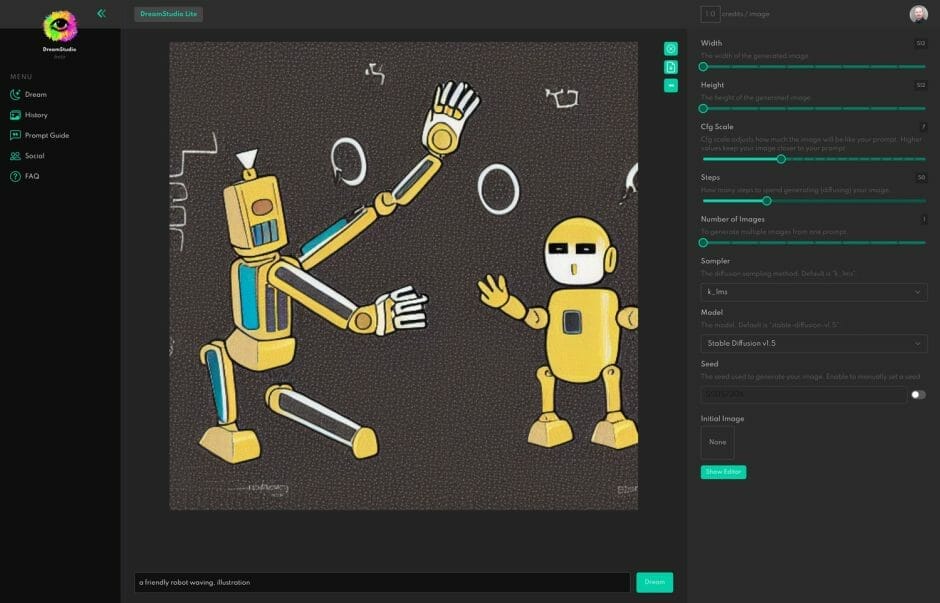

Ein offizielles Angebot für Stable Diffusion ist das DreamStudio. Hier nutzt du es einfach im Browser. Du bekommst einige „Credits“ kostenlos für deine Experimente. Der große Vorteil: Hier generieren spezialisierte Server die Bilder. Entsprechend kurz sind die Wartezeiten. Zudem musst du nichts einrichten und konfigurieren wie bei der Installation von Stable Diffusion auf deinem eigenen Rechner. Nutze auf dieser Login-Seite die „Sign up“-Funktion, um dir deinen Account anzulegen. Gefallen dir die Ergebnisse, kannst du unkompliziert weitere Credits hinzufügen. Auch hier gibt es keine laufenden monatlichen Kosten.

Willst du Stable Diffusion hingegen selbst installieren, findest du es hier auf GitHub. Es gibt ergänzend u.a. diese Benutzeroberfläche für den Browser.

Das Unternehmen hinter Stable Diffusion, Stability AI, hat in einer ersten Finanzierungsrunde 101 Millionen US-Dollar von Investoren eingesammelt.

Weitere Angebote auf einen Blick:

- Wombo Dream (App, Web, kostenlos mit Werbung, Premium-Option)

- Craiyon, ehemals Dall-E mini (Web, Android, kostenlos mit Werbung)

- MidJourney (offene Beta, nutzt Discord als Plattform, kostenlose Option mit weniger Funktionen sowie Premium-Angebot, hier legst du dir deinen Zugang an)

- OpenAI Dall-E (hier anmelden, 50 Credits gratis, dann 15 Credits gratis pro Monat)

- Google Imagen (reines Forschungsprojekt, nicht für die Öffentlichkeit)

Einige Fachbegriffe kurz erklärt

Wenn du dich mit KI-Bildgeneratoren beschäftigst, werden dir einige ungewohnte Begriffe begegnen:

- img2img: Dieser Artikel dreht sich vor allem darum, wie diese Generatoren Bilder aus Textvorgaben erstellen. Du kannst aber ebenso ergänzend ein Bild vorgeben. Das kann eine simple Skizze sein oder eine ausgewachsene Grafik. Das Tool nimmt dann dieses Bild als Ausgangspunkt. Das ist praktisch, wenn du das Ergebnis stärker beeinflussen willst. Ein weiterer Anwendungsfall sind kleinere Änderungen an einem vorhandenen Bild. Beispiel: Du hast ein Foto gefunden, das dir gefällt, aber die Person darauf lächelt und das wäre unpassend. Du könntest nun über einen KI-Bildgenerator und eine img2img-Funktion nur dieses Detail anpassen.

- Outpainting: Ein Bildgenerator wie Dall-E kann nicht nur ein Bild in der vorgegeben Größe erzeugen, sondern auch ein Ergebnis nehmen und weitere Teile hinzufügen. So könntest du zunächst das zentrale Motiv deines geplantes Bildes erzeugen und in den nächsten Schritten dann den Hintergrund und die Umgebung.

- Inpainting: Mit dieser Funktion kannst du Teile eines Bildes verändern und ersetzen.

- Prompt: Die Textvorgabe, auf dessen Basis das Bild erzeugt wird.

- Prompt Engineering: Die Kunst, die Textvorgabe für das Bild immer weiter zu verfeinern, um das gewünschte Ergebnis zu erzielen. Hier kommt es unter anderem darauf an, die richtige Begrifflichkeiten zu finden oder auch passende Kunststile und Künstler. Beispiele siehst du auf der oben schon erwähnten Suchmaschine Lexica. Und als Hilfe gibt es den Stable Diffusion Prompt Generator, der die Angaben auf dieser Suchmaschine ausgewertet hat. Weiteres Werkzeug ist Phraser: Es leitet dich in mehreren Schritten durch mögliche Optionen (kostenloser Account notwendig fürs Ergebnis).

Welche Kritikpunkte solltest du kennen?

KI-Bildgeneratoren erleben derzeit einen großen Hype. Aber bei aller Begeisterung für die neuen Möglichkeiten sollten die Kritikpunkte nicht in Vergessenheit geraten:

- Die Generatoren funktionieren nicht so schnell und einfach, wie mancher Bericht es suggeriert. Schon die richtige Textvorgabe ist eine Kunst für sich. Aber selbst wenn du eine gute Kombination aus Textvorgabe und Optionen findest, sind oftmals Nacharbeiten notwendig. Die weit überwiegende Zahl der Ergebnisse ist unbrauchbar. So versteht die KI letztlich (noch) nicht, dass ein Mensch normalerweise nicht vier Arme und sieben Finger hat. Gesichter, Hände und Text sind weitere Problemfelder.

- Die Dienste wurden anhand öffentlich verfügbarer Bild-Text-Kombinationen trainiert. Stable Diffusion nutzte dafür beispielsweise einen Datensatz aus Deutschland (eine Teilmenge von LAION-5B um genau zu sein). Die Urheberrechtsinhaber wurden dazu aber nicht befragt. Und wie im Internet üblich können diese Daten beispielsweise typische Vorurteile widerspiegeln und dadurch noch verstärken.

- Die KI ist nur stark eingeschränkt kreativ. Ihre Ergebnisse basieren auf den gelernten Bild-Text-Paaren und den Texteingaben der Nutzer:innen. Mit anderen Worten: Die Bilder imitieren oftmals bereits vorhandene Stile, entwickeln aber nicht so ohne Weiteres einen neuen. Das mag sich mit fortschreitender Technik und mehr Kreativität in der Nutzerschaft noch ändern. Interessant ist es beispielsweise, mit absichtlich widersprüchlichen oder unsinnigen Eingaben zu experimentieren.

- Darüber hinaus lassen sich alle Arten von Bildern erzeugen – auch solche, die gegen Marken- und Persönlichkeitsrechte verstoßen, Gewalt verherrlichen oder als „Deepfake“ etwas zeigen, das in Wirklichkeit nie passiert ist. Anbieter wie OpenAI mit Dall-E oder Google mit Imagen versuchen, solche Bilder zu verhindern, in dem sich etwa Gesichter von Prominenten schlicht nicht generieren lassen. Das offene Stable Diffusion hat diese Einschränkungen zumindest technisch nicht. Dort steht allein die Nutzungslizenz im Weg.

- Kritisiert wird außerdem, dass diese Dienste die Werke der Künstler:innen stehlen würden. Das basiert meist auf einem Missverständnis dazu, wie sie funktionieren. Es lassen sich zwar Bilder im Stil bestimmter Vorbilder erstellen. Aber die sind eher inspiriert von dem, was sie aus dem Datensatz gelernt haben. Die Generatoren kopieren die Bilder nicht direkt. Trotzdem ist es rechtlich und ethisch problematisch, wenn sich beispielsweise Werke im Stil einer lebenden Person erstellen lassen. In den USA mag das im Zuge des „Fair Use“ eventuell in Ordnung sein. Wie es international aussieht, ist offen.

- Vollkommen unklar und sehr komplex ist außerdem die Frage des Copyrights und Urheberrechts für die entstehenden Werke. Wem gehören die Bilder? Dem Anbieter der KI, weil sie das Werkzeug zur Verfügung stellen? Den Nutzer:innen, weil von ihnen schließlich die Textvorgabe und Einstellungen kommen? Oder den Urheber:innen des Trainingsmaterials? Wer diese Werkzeuge professionell einsetzen will, sollte sich auf jeden Fall mit den jeweiligen Nutzungsbedingungen auseinandersetzen und im Zweifel auch mit einer versierten Person vom Fach sprechen. Ich habe mich mit Rechtsanwalt Dr. Carsten Ulbricht dazu unterhalten, ob KI-Bildgeneratoren in Deutschland überhaupt legal sind.

Wofür lassen sich KI-Bilder und -Illustrationen einsetzen?

Wir stehen weiterhin am Anfang einer Entwicklung. Genauso wie Textgeneratoren deutlich besser geworden sind, wird es für Bilder und Illustrationen Systeme und Methoden geben, die sichtbar besser funktionieren als die heutigen.

Faszinierend finde ich diese Entwicklung vor allem, da ich immer wieder illustrierende Bilder und Grafiken für Beiträge benötige. Heute nutze ich dazu einen Service wie Depositphotos. Die Werke stammen dort von Menschen und sind mit Titel, Beschreibung und Schlagworten versehen. Ich kann meinen Suchbegriff eingeben und die Ergebnisse über Filter eingrenzen. Das funktioniert in vielen Fällen recht gut.

Eine Seite wie Pexels ist wiederum nützlich, wenn ich bereits eine konkrete Bildidee habe. Dann lässt sich hier nach passenden Fotos suchen.

Ich muss aber in beiden Fällen damit leben, was ich finde. Farben anzupassen, eine Pose, den Hintergrund oder andere Details erfordert teils erheblichen Aufwand. Mit der „Inpainting“-Funktion mancher KI-Bildertools (siehe oben) könnte ich nun eine solche Vorlage nehmen und anpassen.

Ich verstehe bei alldem natürlich, dass Grafiker und Fotografen ebenfalls überleben wollen. Mir als Contentmensch geht es nicht anders. Aber ich weiß zugleich, dass sich längst nicht jede:r meine Dienste leisten kann. Alternativ greift man dann auf Texterplattformen zurück oder engagiert jemanden mit weniger Berufserfahrung und niedrigeren Preisen – die dann vielleicht einen KI-Textgenerator nutzen, um schneller Ergebnisse zu erzielen.

Tools, Tipps, News zu KI für Kreative

Der kostenlose Smart Content Report liefert dir alle 14 Tage:

- eine Anleitung mit Tipps aus der Praxis

- aktuelle News rund um neue Tools, Angebote und Entwicklungen

- Links auf lesenswerte Artikel

Kein Spam! 100% nützlich. Schon über 200 Leser:innen sind dabei.

Ähnlich sehe ich den Fall bei Bildern und Illustrationen: Eine maschinengenerierte Variante wird vielleicht nicht dieselbe Kreativität und Kraft haben wie die menschliche (wobei ich mir auch hier nicht sicher bin, ob Maschinen nicht eine ganz eigene Form von Kreativität und Stil entwickeln können). Aber sie wird dennoch hilfreich und nützlich sein, um eine zusätzliche Option zu geben.

Vor allem illustrative Grafiken und Schmuckbilder sind ein Bereich, den ich mir bereits heute gut für diese Werkzeuge vorstellen kann.

Eine weitere mögliche Anwendung ist die Ideenfindung: Eine Designerin kann damit in einfachen Worten eine Idee beschreiben und sich erste Entwürfe generieren lassen. Die nimmt sie dann als Ausgangspunkt für die eigene Arbeit, für den Austausch mit Kolleg:innen oder eventuell für Kundengespräche.

Künstler:innen können diese Generatoren also als neues Werkzeug für ihre kreative Arbeit nutzen. Sie werden dann eher nicht ganze Bilder damit erstellen, aber Elemente daraus.

Es gibt auch eher überraschende Anwendungsfelder. Ein Medium-Artikel untersucht beispielsweise, inwiefern sich Stable Diffusion für die Bildkomprimierung einsetzen lässt.

Schlusswort

Ich gebe zu, dass ich von den Möglichkeiten dieser Werkzeuge fasziniert bin. Der Fortschritt ist atemberaubend und wir stehen noch immer am Anfang.

Niemand sollte den Fehler begehen, das Potenzial solcher Tools zu unterschätzen, selbst wenn die Ergebnisse heute oftmals noch unbrauchbar sind – oder nur mit großer Mühe brauchbar werden.

Die Kosten, solche KI-Tools zu trainieren, werden sinken, wodurch es noch mehr Anbieter geben wird. Adobe hat inzwischen mit Firefly seinen eigenen Generator vorgestellt. Ebenso der bekannte Stockfoto-Anbieter Shutterstock.

Die Möglichkeiten enden bei alldem nicht mit Fotos. Es gibt erste Werkzeuge, die Videos aus solchen Textvorgaben generieren. Ebenso möglich ist das für Audio, Computerspiele oder 3D-Modelle.

Emad Mostaque von Stable Diffusion stellt sich das letztlich so vor wie das „Holodeck“ in Star Trek, das eine Szenerie nach Vorgabe erstellt. Kombiniert man diese Idee mit der Diskussion rund ums Metaverse, wird ein weiteres Stück Science Fiction zur Realität.

Ich möchte an dieser Stelle nicht naiv erscheinen. Die Kritik an dieser neuen Technik ist berechtigt. Zugleich sollte man sie deshalb aber nicht etwa generell verteufeln.

Dieser Artikel gehört zu: UPLOAD Magazin 100

100 Ausgaben UPLOAD Magazin sind ein guter Anlass nach vorn zu schauen: Wohin geht die Reise in den nächsten 10 Jahren? Dazu haben 12 Personen in ihre Glaskugeln geschaut. Die Ergebnisse findest du in dieser Ausgabe. Außerdem erklären wir, was es mit dem Schlagwort „Web3“ auf sich hat, was du heute über das „Metaverse“ wissen musst und wie gut KI-Bildgeneratoren funktionieren.

- Weitere Artikel aus dieser Ausgabe kostenlos auf der Website lesen ...

- Bleib auf dem Laufenden über neue Inhalte mit dem „Update am Montag“ …

Schon gewusst? Mit einem Zugang zu UPLOAD Magazin Plus oder zur Content Academy lädst du Ausgaben als PDF und E-Book herunter und hast viele weitere Vorteile!

Jan hat mehr als 20 Jahre Berufserfahrung als Online-Journalist und Digitalpublizist. 2006 hat er das UPLOAD Magazin aus der Taufe gehoben. Seit 2015 hilft er als CONTENTMEISTER® Unternehmen, mit Inhalten die richtigen Kunden zu begeistern. Und gemeinsam mit Falk Hedemann bietet er bei UPLOAD Publishing Leistungen entlang der gesamten Content-Marketing-Prozesskette an. Der gebürtige Hamburger lebt in Santa Fe, New Mexico.